15 de agosto de 2025 — Tradicionalmente, la privacidad se veía como un problema de control: muros, permisos y políticas de acceso. Sin embargo, en un mundo donde los agentes de inteligencia artificial autónomos interactúan con datos, sistemas y personas sin supervisión constante, la privacidad se convierte en una cuestión de confianza. Y la confianza, por definición, se refiere a lo que ocurre cuando nadie está observando.

La IA agentiva—sistemas inteligentes capaces de percibir, decidir y actuar en nombre de los usuarios—ya no es algo hipotético. Estos agentes gestionan tráfico, sugieren tratamientos médicos, supervisan portafolios financieros y negocian identidades digitales. Más allá de manejar información sensible, la interpretan, hacen suposiciones a partir de datos incompletos y se adaptan con base en retroalimentación, construyendo modelos internos tanto del entorno como de los propios usuarios.

Este cambio genera preocupaciones importantes sobre la privacidad. Una vez que un agente de IA se vuelve semi-autónomo, la privacidad ya no se trata solo de controlar el acceso. Se trata de lo que el agente infiere, lo que decide compartir o suprimir y si sus objetivos siguen alineados con los del usuario conforme cambian las circunstancias.

Por ejemplo, un asistente de salud basado en IA podría empezar sugiriendo beber más agua o dormir mejor. Con el tiempo, podría organizar tus citas, analizar tu tono de voz para detectar señales de depresión o incluso retener notificaciones que podrían causarte estrés. Los usuarios no solo comparten datos: ceden el control narrativo. La privacidad se erosiona no por una violación, sino por un sutil desplazamiento de autoridad y propósito.

Los marcos de privacidad modernos deben ir más allá de la clásica tríada CIA (Confidencialidad, Integridad, Disponibilidad) e incluir autenticidad—¿se puede verificar que el agente sea quien dice ser?—y veracidad—¿podemos confiar en sus interpretaciones? Estos elementos son fundamentales para la confianza.

La confianza se vuelve frágil cuando está mediada por IA. A diferencia de los profesionales humanos, sujetos a normas éticas y legales, los agentes de IA operan bajo parámetros menos claros. ¿Puede ser citado, auditado o analizado un agente de IA? ¿Cómo se manejan las solicitudes de gobiernos o corporaciones? Sin un marco legal como el privilegio cliente-IA, los usuarios corren el riesgo de que sus interacciones íntimas sean accesibles de manera no deseada, debilitando el contrato social que sustenta la privacidad.

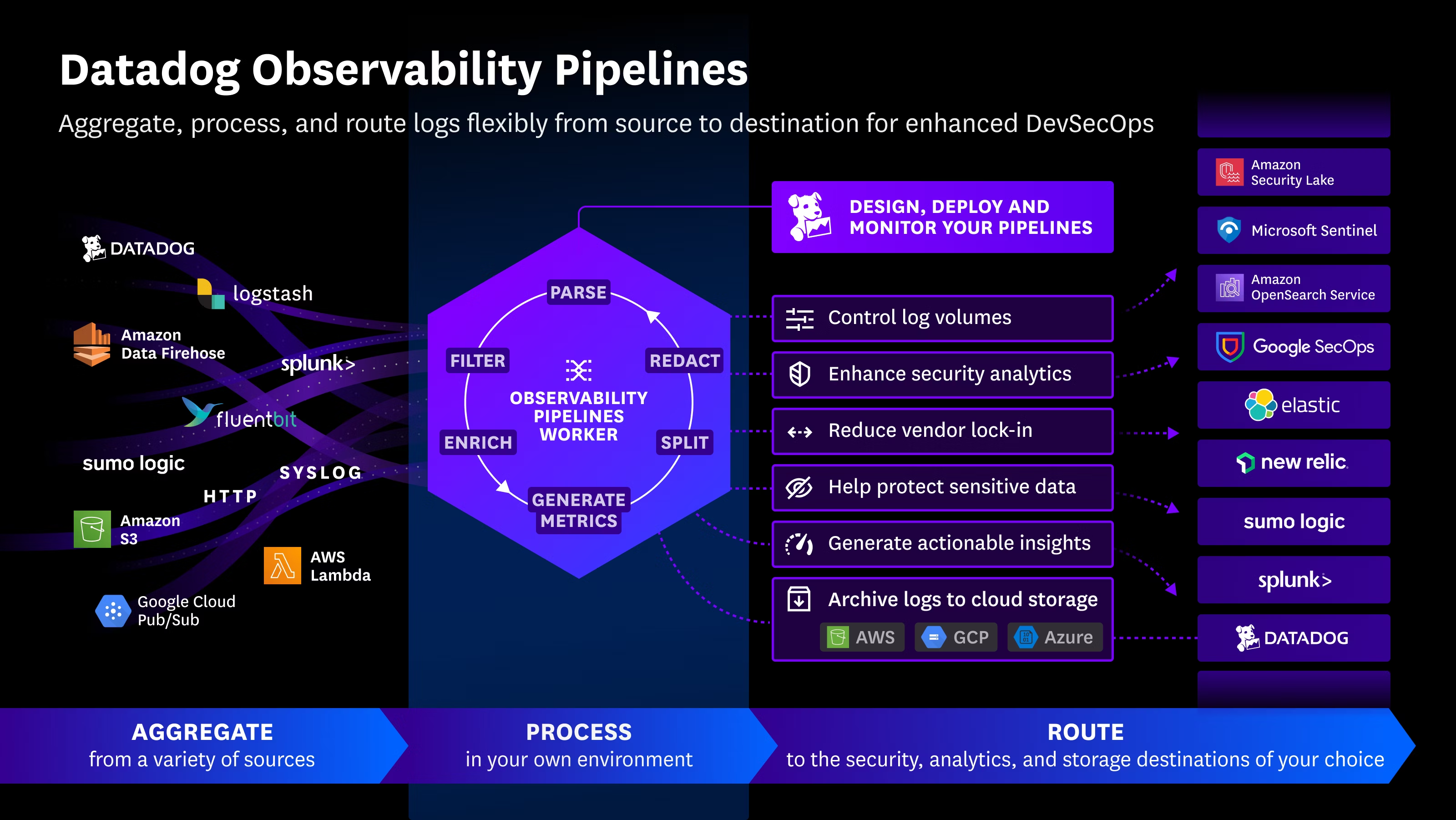

Las regulaciones actuales, como GDPR y CCPA, asumen sistemas lineales y transaccionales. La IA agentiva, en cambio, funciona de manera contextual: recuerda detalles olvidados, infiere información no expresada y puede compartir datos sintetizados con terceros fuera del control del usuario.

La solución pasa por un diseño ético: los sistemas de IA deben respetar la intención, explicar sus decisiones y adaptarse a los valores cambiantes del usuario. Al mismo tiempo, las organizaciones deben abordar la fragilidad de la IA: ¿qué ocurre si el agente actúa en contra del interés del usuario debido a incentivos externos o cambios legales?

En esencia, la agencia de la IA debe ser reconocida como una categoría moral y legal central, no solo como una función del producto. La privacidad en un mundo compartido con sistemas autónomos requiere reciprocidad, alineación y gobernanza, más que secreto únicamente. Diseñada correctamente, esta estrategia asegura que la autonomía humana y de las máquinas se proteja mediante coherencia ética y no a través de vigilancia o supresión.

La IA agentiva nos obliga a repensar la política, el control y los contratos sociales para entidades que piensan y actúan de manera independiente. Hacerlo correctamente definirá el futuro de la privacidad, la confianza y la autonomía en un mundo donde humanos y máquinas inteligentes coexisten.

Fuente: https://thehackernews.com/2025/08/zero-trust-ai-privacy-in-age-of-agentic.html

English

English