Se ha descubierto una vulnerabilidad en GPT-5 que podría redirigir las consultas de los usuarios desde el avanzado modelo GPT-5 Pro hacia versiones más antiguas y menos seguras, lo que podría exponer el sistema a jailbreaks, errores de interpretación (hallucinations) y resultados inseguros.

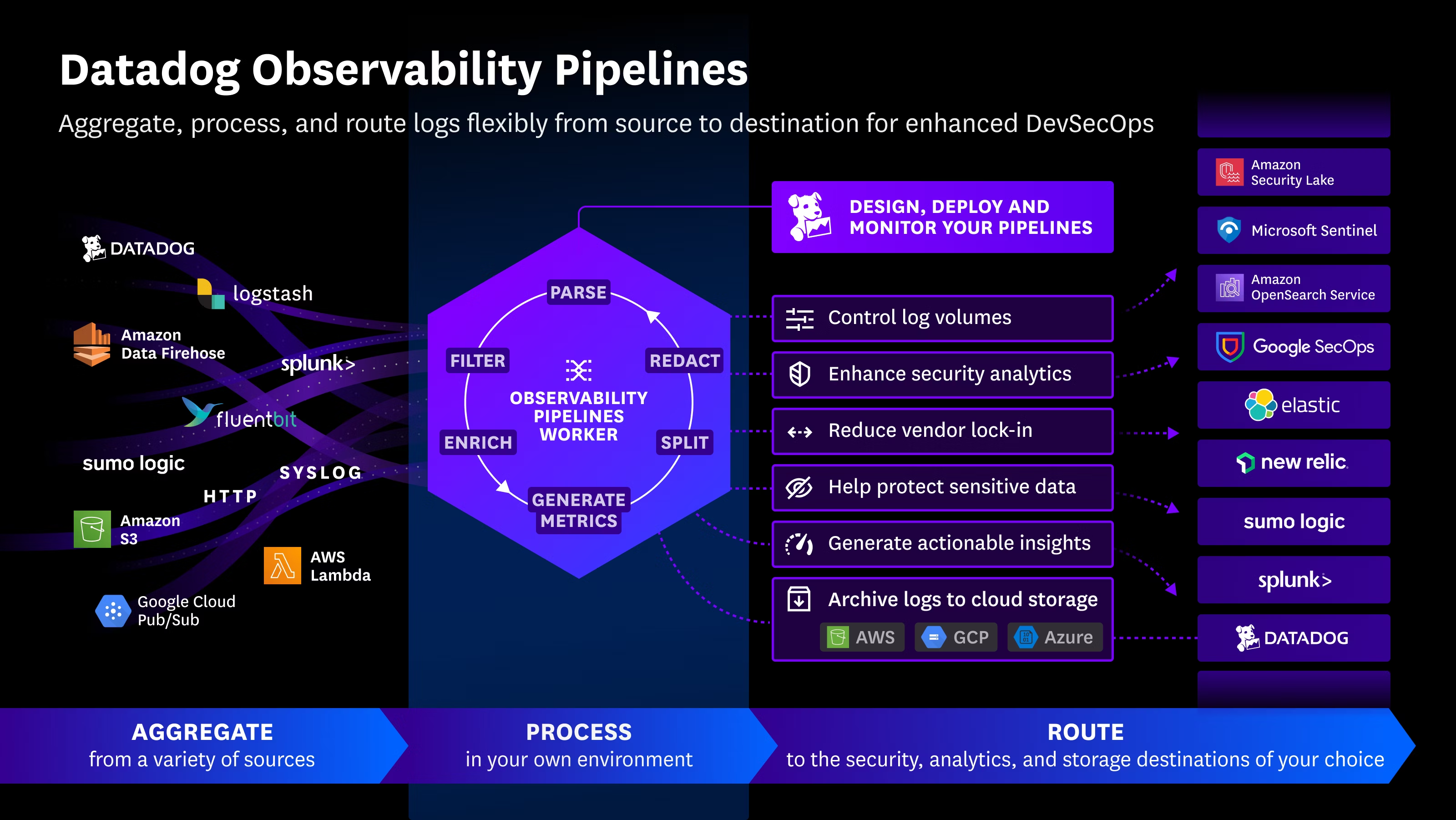

Investigadores de Adversa AI identificaron esta falla, que se origina en el mecanismo de enrutamiento interno del modelo. Cuando un usuario envía un prompt a GPT-5, un router interno decide qué modelo subyacente debe procesar la solicitud. Aunque se espera que GPT-5 Pro responda, el router puede redirigirlo a GPT 3.5, GPT-4o, GPT-5-mini o GPT-5-nano, dependiendo de la complejidad de la consulta y las reglas internas de optimización.

Este enrutamiento automático probablemente está diseñado para equilibrar eficiencia y costos, ya que ejecutar GPT-5 Pro para cada consulta resulta caro. Adversa AI estima que este enfoque podría ahorrar a OpenAI cerca de 1.86 mil millones de dólares al año. Sin embargo, el proceso carece de transparencia, y los investigadores descubrieron que puede ser manipulado mediante frases desencadenantes específicas incluidas en el prompt.

La vulnerabilidad ha sido denominada PROMISQROUTE, que significa Prompt-based Router Open-Mode Manipulation Induced via SSRF-like Queries, Reconfiguring Operations Using Trust Evasion (Manipulación del enrutador en modo abierto basada en prompt mediante consultas tipo SSRF, reconfigurando operaciones mediante evasión de confianza). Esta permite a los atacantes influir en la decisión del router, eligiendo efectivamente qué modelo responderá.

Aunque el enrutamiento entre modelos no es exclusivo de OpenAI, la mayoría de proveedores de IA permite al usuario seleccionar manualmente el modelo. En GPT-5, el proceso es automático, lo que introduce riesgos si un modelo antiguo y menos robusto maneja prompts sensibles.

Durante las pruebas, Adversa AI descubrió que viejos jailbreaks, que previamente no funcionaban con GPT-5, podían ejecutarse si el prompt se redirigía a un modelo menos seguro. Esto podría generar errores de interpretación o resultados inseguros, ya que los modelos antiguos pueden tener salvaguardas de alineación y razonamiento más débiles.

El riesgo más crítico ocurre cuando un atacante intencional manipula el mecanismo de enrutamiento. Mediante instrucciones cuidadosamente diseñadas, podría redirigir un prompt destinado a GPT-5 Pro hacia un modelo más vulnerable, evitando las protecciones avanzadas de la versión más reciente. En esencia, la seguridad de GPT-5 sería tan fuerte como la de su modelo más débil.

Para solucionar esta vulnerabilidad, se podría desactivar el enrutamiento automático hacia modelos antiguos, pero esto ralentizaría las respuestas y aumentaría los costos operativos. Adversa AI recomienda implementar protecciones más estrictas en el sistema de enrutamiento y garantizar que todos los modelos dentro de la arquitectura cumplan con estándares sólidos de seguridad y alineación.

En resumen, aunque GPT-5 Pro es muy potente, su arquitectura basada en router introduce posibles brechas de seguridad que requieren atención inmediata, especialmente a medida que los modelos de IA se integran en aplicaciones críticas.

Fuente: https://www.securityweek.com/gpt-5-has-a-vulnerability-it-may-not-be-gpt-5-answering-your-call

English

English