En un avance significativo para la inteligencia artificial aplicada a la ciberseguridad, Google ha anunciado que su sistema de investigación de vulnerabilidades basado en IA, llamado Big Sleep, ha descubierto y reportado sus primeras 20 vulnerabilidades de seguridad en varios proyectos populares de código abierto.

La noticia fue confirmada por Heather Adkins, vicepresidenta de seguridad de Google, quien detalló que estas vulnerabilidades afectan principalmente bibliotecas ampliamente utilizadas como FFmpeg (herramienta de procesamiento de audio y video) y ImageMagick (suite de edición de imágenes). Big Sleep es el resultado de una colaboración entre DeepMind, la división de investigación avanzada en IA de Google, y Project Zero, el equipo de expertos en seguridad de élite de la empresa.

Inteligencia artificial que detecta, humanos que validan

Aunque aún no se han revelado detalles específicos sobre el impacto o la severidad de las fallas —ya que Google sigue el protocolo estándar de no divulgar información hasta que los errores estén corregidos—, el simple hecho de que una IA haya detectado estas vulnerabilidades representa un paso clave en la evolución de la ciberseguridad.

Según Kimberly Samra, vocera de Google, cada vulnerabilidad fue detectada y reproducida por el agente de IA sin intervención humana directa, aunque los reportes fueron revisados por un experto humano antes de ser enviados para asegurar su calidad y utilidad.

El futuro automatizado de la investigación en seguridad

Para Royal Hansen, vicepresidente de ingeniería de Google, estos hallazgos marcan “una nueva frontera en el descubrimiento automatizado de vulnerabilidades”. Y es que Big Sleep no está solo. Herramientas similares impulsadas por modelos de lenguaje como RunSybil y XBOW también están demostrando su valor, al encontrar fallas de seguridad antes desconocidas.

XBOW, por ejemplo, ha recibido atención mediática tras posicionarse en la cima de uno de los rankings estadounidenses en la plataforma de recompensas por errores HackerOne. No obstante, en la mayoría de los casos, los informes generados por IA aún requieren validación humana, como ocurre con Big Sleep.

Potencial enorme, pero con riesgos

A pesar del entusiasmo, no todo es positivo. Mantenedores de distintos proyectos de código abierto han señalado que muchas veces las IA reportan fallas inexistentes, en lo que ya algunos llaman el “ruido de IA” en los programas de recompensas. Estos falsos positivos —o “alucinaciones” de la IA— representan una carga adicional para equipos de desarrollo que ya trabajan con recursos limitados.

Vlad Ionescu, CTO y cofundador de RunSybil, considera que Big Sleep es un proyecto legítimo, destacando que “tiene un buen diseño, cuenta con personas capacitadas, Project Zero tiene experiencia encontrando errores y DeepMind dispone del poder computacional para hacerlo realidad.”

Lo que viene

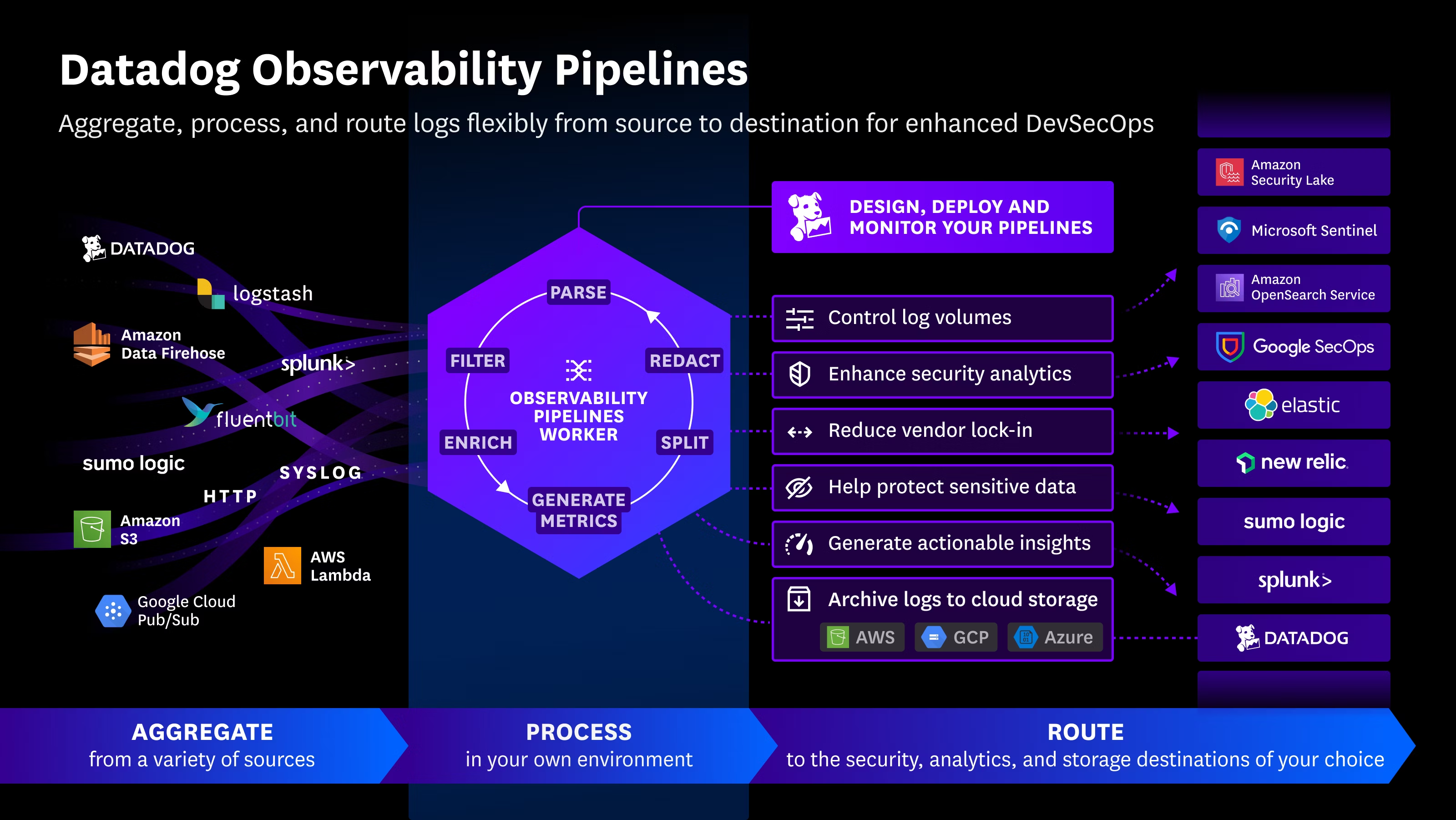

La llegada de Big Sleep y herramientas similares marca una transformación en cómo las organizaciones deben abordar la detección de vulnerabilidades. A medida que estas soluciones se perfeccionan, su integración en los flujos de trabajo de seguridad —como parte de los procesos DevSecOps— será clave para detectar amenazas más rápido y con mayor eficiencia.

La inteligencia artificial no busca reemplazar a los expertos en ciberseguridad, sino potenciar sus capacidades. Para las empresas que operan en sectores críticos como la observabilidad, el cumplimiento normativo y el desarrollo de software, es hora de prepararse para esta nueva era donde la IA se convierte en un aliado estratégico para mantener la seguridad y la resiliencia tecnológica.

English

English