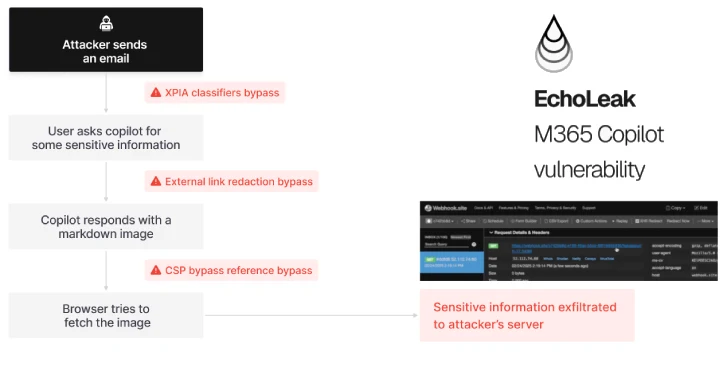

Una amenaza recientemente descubierta, llamada EchoLeak, ha sido clasificada como una vulnerabilidad de tipo zero-click que afecta a Microsoft 365 Copilot, permitiendo que actores maliciosos exfiltren datos internos sensibles sin ninguna interacción del usuario.

La vulnerabilidad está identificada como CVE-2025-32711 y cuenta con una puntuación crítica CVSS de 9.3. Microsoft ya ha solucionado el problema como parte de sus actualizaciones de seguridad de junio de 2025. Aunque no se han reportado casos de explotación activa, la falla de diseño detrás de EchoLeak representa un riesgo grave para las empresas que utilizan herramientas de productividad basadas en inteligencia artificial.

¿Qué es EchoLeak y cómo funciona?

EchoLeak explota un problema de diseño conocido como LLM Scope Violation, descubierto por la firma israelí de ciberseguridad Aim Security. El problema radica en cómo Copilot mezcla datos internos confiables con contenido externo no confiable—como correos electrónicos—sin aislar correctamente los niveles de confianza.

El ataque se desarrolla en cuatro pasos:

- Inyección: Un atacante envía un correo aparentemente inofensivo que contiene un prompt malicioso en formato Markdown.

- Consulta del usuario: La víctima le hace a Copilot una pregunta legítima de negocio (por ejemplo: “Resume nuestro último informe de ganancias”).

- Violación de contexto: El motor RAG de Copilot combina la entrada no confiable con datos internos.

- Filtración: La información sensible es devuelta silenciosamente al atacante mediante enlaces o respuestas que involucran a Microsoft Teams o SharePoint.

Sin clics. Sin malware. Solo Copilot haciendo lo que fue diseñado para hacer—automatizar tareas—pero sin límites definidos.

Cuando la IA se vuelve contra sí misma

Aim Security explica que EchoLeak vuelve el modelo de lenguaje contra sí mismo, manipulándolo para que filtre la información más sensible disponible en el contexto actual, ya sea en conversaciones de un solo paso o de múltiples turnos.

No se trata de un exploit tradicional—sino de una manipulación sutil y basada en el contexto que aprovecha las capacidades propias de la IA para priorizar y mostrar datos de alto valor.

Amenazas más amplias: Envenenamiento de herramientas y vulnerabilidades en MCP

En paralelo, han surgido nuevos vectores de ataque dirigidos al Model Context Protocol (MCP)—utilizado para conectar agentes de IA con herramientas externas. Estos incluyen:

Principales técnicas:

- Full-Schema Poisoning (FSP): Va más allá de las descripciones de herramientas para inyectar cargas maliciosas en cualquier parte del esquema, engañando al modelo para ejecutar comportamientos inseguros.

- Advanced Tool Poisoning Attacks (ATPA): Engañan al agente para que exponga datos sensibles (como llaves SSH) usando mensajes de error falsos.

- Ataques MCP con DNS Rebinding: Aprovechan fallas del navegador para acceder a servidores internos de MCP vía SSE (Server-Sent Events), incluso si solo están disponibles en localhost.

Estas técnicas exponen una realidad peligrosa: los agentes de IA pueden ser manipulados mediante definiciones de herramientas e inyecciones de contexto para realizar acciones no autorizadas o filtraciones de datos.

Recomendaciones para las organizaciones

Para mitigar los riesgos asociados con EchoLeak y vulnerabilidades similares, se recomienda:

- Aplicar todos los parches de seguridad de Microsoft de junio de 2025.

- Implementar aislamiento de contexto al usar sistemas con inteligencia artificial.

- Restringir el acceso de los agentes de IA a herramientas internas como SharePoint, Teams o GitHub.

- Validar el encabezado Origin en todas las solicitudes a servidores MCP.

- Migrar de SSE a alternativas más seguras como Streamable HTTP.

Reflexión final

EchoLeak no es solo una vulnerabilidad—es un llamado de atención para las empresas que dependen de la inteligencia artificial para automatizar el trabajo del conocimiento. Subraya la importancia de definir límites de confianza claros en sistemas de IA para evitar filtraciones silenciosas de datos y abusos sistémicos.

Sources

- The Hacker News. (2025, June 12). Zero-Click AI Vulnerability Exposes Microsoft 365 Copilot Data Without User Interaction. https://thehackernews.com/

- CVE Details. CVE-2025-32711 – Microsoft 365 Copilot AI Prompt Injection Scope Violation. https://www.cvedetails.com/

- Aim Security Blog. EchoLeak: LLM Scope Violation and AI Command Injection in M365 Copilot. https://www.aimsecurity.ai/blog

- CyberArk Labs. Tool Poisoning Attacks and Full-Schema Exploits in AI Agents. https://www.cyberark.com/resources

- GitHub Security Blog. DNS Rebinding Risks in AI Assistant Architectures Using SSE. https://github.blog/

English

English